OpenAI の頭脳である Sam Altman 氏は、Twitter でライブ ストリームを発表した後、新しい LLM モデルを発表しました。

GPT-4o は、マルチモーダル入力を受け入れることができる LLM モデルの最新の改良版です。音声、テキスト、画像コマンドを簡単に理解できます。

OpenAI は GPT-4o を統合していますチャットGPTそして、ペイウォールの内側で新しい LLM を制限しません。

GPT-4o はどれくらい優れていますか?

以前のモデルと比較して、GPT-4o は大幅に高速になっています。によるとサムが共有した画像、モデルはすべての日常的なタスク、特にコーディングにおいて優れています。

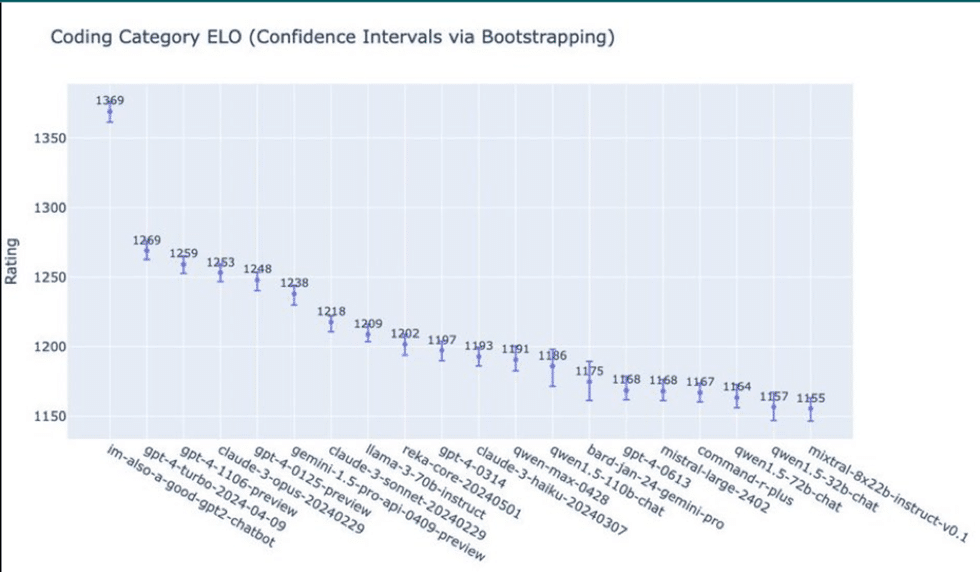

このモデルは、他の古い GPT モデルやさまざまな会社の LLM と比較して、総合評価 1310 を獲得しました。

コーディング部門では 1369 点を獲得し、他のモデルを 1 マイルリードしました。

サムは引き続き、すべての部門で新しいモデルのデモンストレーションを行いました。ビデオ クリップでは、プレゼンターが音声機能を使用して GPT-4o を搭載した ChatGPT と対話している様子が示されています。

驚いたことに、あなたが古い友人と話している間、AI アシスタントは人間のような口調とピッチを維持しました。

の公式ウェブページは、「音声入力にわずか 232 ミリ秒で応答でき、平均は 320 ミリ秒です。」と主張しています。

これらの数値は、新しいモデルが会話における人間の応答率に非常に近いことを示しています。

音声インタラクションは、ほとんどの音声アシスタントのようにロボット的または単調に聞こえませんでした。

サムはその大きな違いを指摘し、「リアルタイムの音声とビデオはとても自然に感じられます」と述べました。

次に、発表者はビデオ モードに切り替えて方程式を書き、新しいモデルがそれを認識してすぐに解決しました。

コーディング デモでは、プレゼンターが指摘した大量のコード スニペットを難なく解釈しました。

GPT-4o は無料ですが、落とし穴があります

GPT-4 モデルの ChatGPT は、有料購読者のみが利用できます。ただし、GPT-4o は、既存の ChatGPT メンバー (無料および有料の両方) 全員が無料で利用できます。

ただし、音声モードGPT-4o アルファ版は、ChatGPT Plus 加入者のみが利用できます。

開発者は、GPT 4 の半額で新しい LLM の API を実際に体験できます。さらに、OpenAI は、この API は 2 倍高速で、5 倍のレート制限があると主張しています。